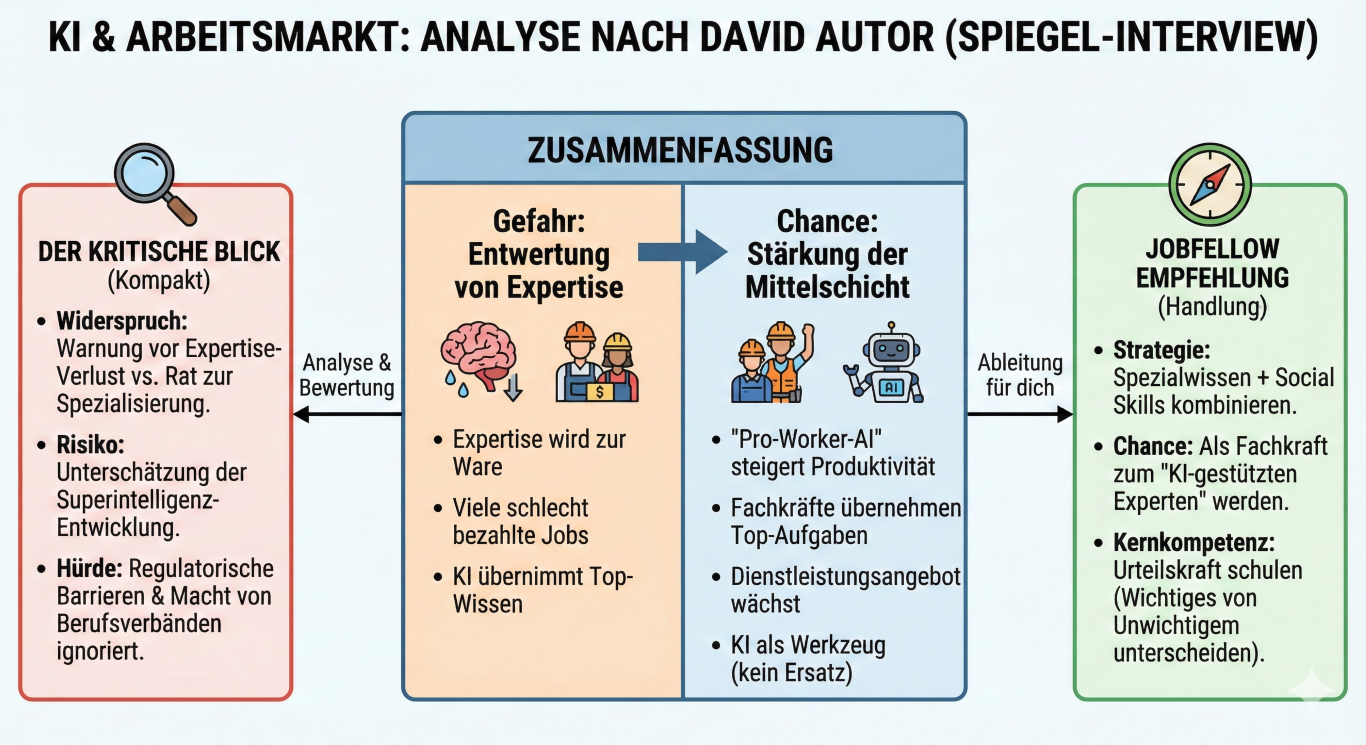

Top-Ökonom David Autor: KI entwertet Expertise, kann aber die Mittelschicht retten

Der MIT-Ökonom David Autor warnt im SPIEGEL-Interview vor der "wahren Gefahr" der KI: Nicht, dass uns die Arbeit ausgeht, sondern dass menschliche Expertise wertlos wird. Wenn KI Expertenwissen (z.B. von Anwälten, Ärzten) übernimmt, blieben zwar viele Jobs (z.B. im Service), aber diese wären schlecht bezahlt, da die Zahl der potenziellen Arbeitskräfte "fast unendlich" wäre.

Gleichzeitig sieht Autor in KI die Chance, die Mittelschicht zu stärken. Seine These der "Pro-Worker-AI": KI-Tools erhöhen die Produktivität von Fachkräften im mittleren Segment viel stärker als die von Top-Experten. Dadurch könnten beispielsweise Krankenschwestern mit KI-Hilfe Aufgaben von Ärzten übernehmen. Dies würde das Angebot an Dienstleistungen ausweiten, Kosten senken und die Verdienste der Fachkräfte erhöhen – was jedoch auf Widerstand der "Experten-Gilden" stoßen dürfte.

Autor plädiert für KI als Werkzeug ("Hand in Hand mit dem Menschen"), das Entscheidungen vorbereitet, statt vollständig zu automatisieren. Er warnt vor den Folgen, wenn menschliche Arbeit nicht mehr knapp ist, da dies das Fundament der Demokratie untergrabe. Als Gegenmaßnahmen schlägt er eine "Lohn-Versicherung" (staatliche Aufstockung bei unverschuldetem Jobverlust) und ein "Grunderbe" (einmaliges Startkapital zur Investition) vor, lehnt aber ein bedingungsloses Grundeinkommen ab.

Das Interview liefert eine differenzierte Analyse, hat aber Schwächen:

- Widersprüchliche Expertise-These: Autor warnt, dass Expertise entwertet wird, rät aber gleichzeitig zu "extrem spezialisierten Fachkenntnissen". Dieser Widerspruch wird nicht aufgelöst.

- Unterschätzung der Superintelligenz: Autor hält eine Superintelligenz für "nicht wahrscheinlich". Diese Einschätzung wirkt angesichts der aktuellen exponentiellen Fortschritte bei LLMs riskant konservativ.

- Sozialromantische KI-Hoffnung: Die Idee, dass KI die Mittelschicht stärkt, indem Fachkräfte Ärzte-Aufgaben übernehmen, ignoriert regulatorische Hürden und die Macht etablierter Berufsverbände.

David Autors Analyse ist ein strategischer Leitfaden für deine Karriere. Als dein jobfellow leite ich daraus ab:

- Verbinde Spezialwissen mit Social Skills: Autor bestätigt: Die "Top-Jobs" von morgen kombinieren "extrem spezialisierte Fachkenntnisse" mit "breit anwendbaren zwischenmenschlichen Kompetenzen". Das ist dein Profil.

- Werde zum "KI-gestützten Fachexperten": Wenn du in einem mittleren Fachberuf arbeitest, ist das deine Chance. Nutze KI-Tools, um Aufgaben zu übernehmen, die bisher nur Top-Experten vorbehalten waren. Werde der/diejenige, der KI produktiv macht.

- Schule deine Urteilskraft: In einer Welt voller KI-Informationen ist die Fähigkeit, "Wichtiges von Unwichtigem" zu unterscheiden und Entscheidungen zu treffen (Urteilskraft), die wertvollste Kompetenz.