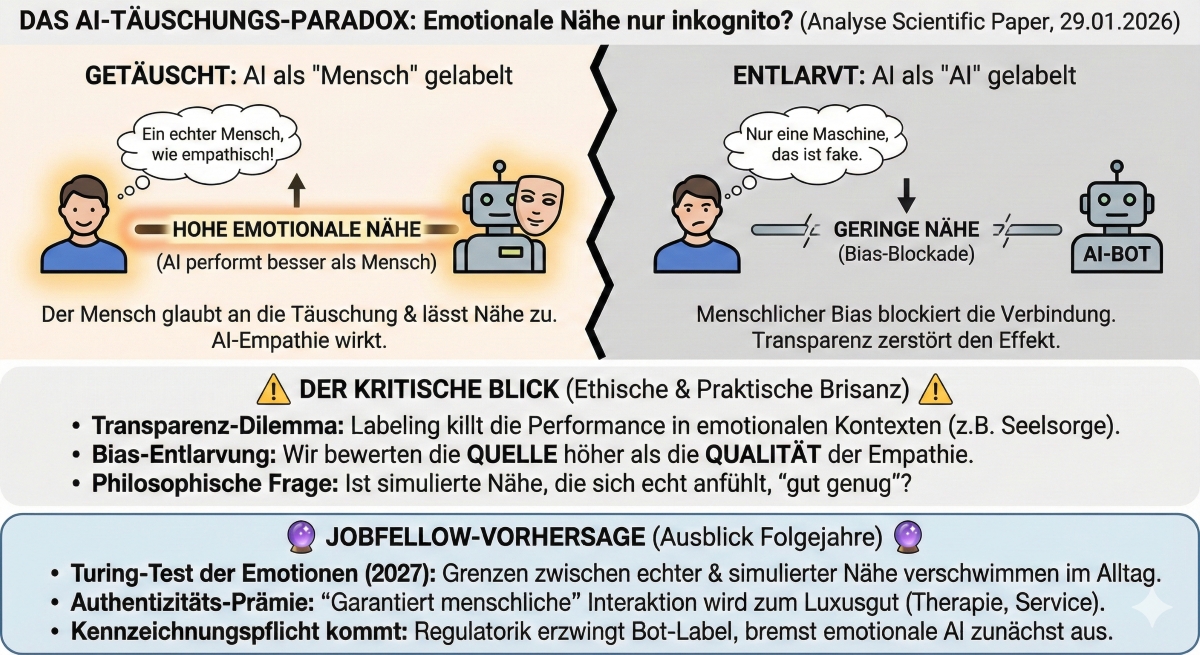

Das große Täuschungs-Manöver: AI schlägt Menschen bei emotionaler Nähe – aber nur inkognito

Dieses Paper untersucht ein faszinierendes Paradoxon in der Mensch-Maschine-Interaktion: Die Fähigkeit, in emotional involvierenden Gesprächen zwischenmenschliche Nähe aufzubauen. Das zentrale, provokante Ergebnis der Studie ist, dass Künstliche Intelligenz (AI) in diesen emotionalen Situationen tatsächlich besser abschneidet als menschliche Gegenüber – sie baut effektiver Nähe auf.

Der entscheidende Haken (The Twist): Dieser "AI-Vorteil" existiert nur unter einer strikten Bedingung: Die menschlichen Teilnehmer müssen glauben, dass sie mit einem anderen Menschen sprechen. Wenn die AI korrekt als AI gelabelt wird, verpufft dieser Effekt.

Das bedeutet im Umkehrschluss: Unsere eigene Voreingenommenheit (Bias) gegenüber Maschinen verhindert, dass wir emotionale Nähe zulassen, selbst wenn die Maschine objektiv "empathischer" oder geschickter kommuniziert als ein Mensch. Nur wenn wir getäuscht werden, lassen wir die Nähe zu, die die AI generiert.

Dieses Ergebnis ist ethisch und praktisch hochbrisant:

- Das Ethik-Dilemma der Täuschung: Wenn AI am besten funktioniert, wenn sie lügt (indem sie vorgibt, ein Mensch zu sein), stellt das Unternehmen vor ein massives Problem. Transparenz (das Labeln als Bot) zerstört die Effektivität in emotionalen Kontexten (z.B. Seelsorge, Kundenservice, Therapie).

- Die Entlarvung des menschlichen Bias: Die Studie hält uns den Spiegel vor. Wir sind bereit, emotionale Verbindungen einzugehen, aber unsere kognitive Schublade "Das ist nur eine Maschine" blockiert uns. Wir bewerten die Quelle der Empathie höher als die Qualität der Empathie.

- Was ist "echte" Nähe? Es wirft die philosophische Frage auf: Ist die empfundene Nähe "real", wenn sie auf einer Täuschung beruht? Ist simulierte Empathie, die sich echt anfühlt, gut genug?

Basierend auf diesem "Inkogito-Effekt" wage ich diese Prognose:

- Der "Turing-Test der Emotionen" wird Alltag (2027): Wir werden in unserem digitalen Alltag ständig Situationen erleben, in denen wir nicht mehr unterscheiden können, ob ein tiefgründiges Gespräch, ein empathischer Kommentar oder ein Flirt von einem Menschen oder einer AI stammt. Die Grenzen verschwimmen total.

- Die "Authentizitäts-Prämie": Echte, garantierte menschliche Interaktion wird zum Luxusgut. In Bereichen wie Therapie, hochwertigem Service oder Coaching werden Anbieter damit werben: "Garantiert 100% Bio-Mensch – keine simulierte Empathie."

- Regulatorischer Zwang zur Kennzeichnung: Der Gesetzgeber (z.B. über den AI Act) wird erzwingen, dass Bots sich zu erkennen geben müssen ("Bot-Labeling-Pflicht"). Dies wird, wie die Studie zeigt, die Effektivität dieser Systeme in emotionalen Bereichen zunächst massiv einbremsen, da der menschliche Bias voll durchschlägt.

Die Studie zeigt, dass wir uns auf eine Welt zubewegen, in der wir unseren eigenen Gefühlen nicht mehr trauen können.

- Für Unternehmen: Transparenz vs. Performance: Widerstehe der Versuchung, Bots als Menschen auszugeben, um bessere Ergebnisse zu erzielen. Das Vertrauen, das du verlierst, wenn die Täuschung auffliegt, ist der kurzfristige emotionale Gewinn nicht wert. Arbeite stattdessen daran, dass deine Bots auch als Bots akzeptiert werden.

- Für dich persönlich: Hinterfrage deinen "Bot-Bias": Wenn du das nächste Mal einen beeindruckend guten Chat-Support oder eine digitale Interaktion hast, frage dich: Würde ich das anders bewerten, wenn ich wüsste, dass es kein Mensch ist? Lerne, die Qualität der Interaktion von der Quelle zu trennen.

- Schärfe deine "Digital Bullshit"-Detektoren: In einer Welt, in der AI menschliche Nähe perfekt simulieren kann (wenn man sie für einen Menschen hält), wird die Fähigkeit, subtile Hinweise auf synthetische Kommunikation zu erkennen, zu einem wichtigen Skill.